ChatGPT б’є по Google: директор з застосунків OpenAI розповів про нові функції пошуку

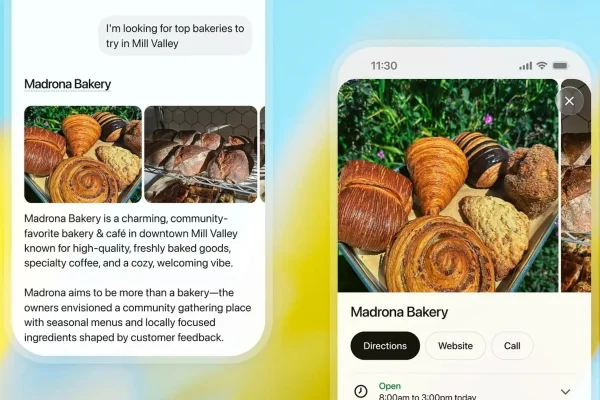

Нові функції ChatGPT можуть змусити користувачів нарешті відмовитися від Google Search: учора OpenAI представила новий досвід роботи з зображеннями в ChatGPT, який працює на базі новітньої моделі генерації зображень GPT Image 1.5. CEO напрямку Applications в OpenAI Фіджі Сімо повідомив про кілька нових функцій, які невдовзі з’являться в ChatGPT. Нова модель значно краще зберігає ключові…